在Python中,实现一个简单的中文分词处理,我们可以采用基于规则的方法,比如最大匹配法、最小匹配法、双向匹配法等。但更常见且效果更好的是使用现有的分词库,如jieba分词。

以下是使用jieba分词库进行中文分词的简单示例:

安装jieba

pip install jieba

代码实现

import jieba

# 要分词的句子

sentence = "我来到北京清华大学"

# 使用jieba进行分词

seg_list = jieba.cut(sentence, cut_all=False)

# 打印分词结果

print("Default Mode: " + "/ ".join(seg_list))

# 添加自定义词典

jieba.add_word("清华大学")

# 再次分词,这次"清华大学"会作为一个词被切出来

seg_list = jieba.cut(sentence, cut_all=False)

print("Custom Dictionary: " + "/ ".join(seg_list))实现自定义分词模型训练

import jieba

# 加载自定义词典

jieba.load_userdict('userdict.txt')

# 使用新模型进行分词

seg_list = jieba.cut("我来到北京清华大学", cut_all=False)

print("Default Mode: " + "/ ".join(seg_list))新词1 5 新词2 新词3 3

转自

CSDN(nihui123)

-

麒麟系统命令行常用快捷键介绍

-

银河麒麟桌面操作系统进不去系统怎么备份用户数据 Livecd备份数据教程

-

七类网线水晶头接法制作步骤教程图解

- Win10安装打印机驱动程序失败提示“试图将驱动程序添加到存储区时遇到问题”解决方法

- Windows系统如何更改软件安装默认位置

- 禁用Windows Update服务,Windows10和11自动更新彻底关闭方法

- 电脑配置如何使用命令查看

- 国产麒麟系统开机没有网络需要点一下这个设置

- 显示this application has requested the runtime to terminate it in an unusual way.问题的简单分析

- 解决打印作业滞留在打印队列中的问题 (Windows)

- 苹果MAC系统安装Alien Skin Eye Candy 软件 提示“已损坏,无法打开”,处理方法

- Python 实现一个简单的中文分词处理?

- 栏目导航

- 最新文章

-

-

麒麟系统命令行常用快捷键介绍

基本快捷键如下:Ctrl+C:终止当前正在运行的命令。当命令卡住或不想继续执行时,可以使用此快捷键强制终止。Ctrl...

-

银河麒麟桌面操作系统进不去系统怎么备份用户数据 Livecd备份数据教程

编写人:张展鹏编写日期:2023/11/27一.操作前准备准备好系统盘和存放数据的光盘或者u盘(有网络的机器登录网页邮箱...

-

七类网线水晶头接法制作步骤教程图解

技发展越来越迅速,我们目睹了综合布线行业的更新迭代,最开始常用的五类线、超五类线渐渐被六类线、超六类、七类线所取代,今天...

-

Win10安装打印机驱动程序失败提示“试图将驱动程序添加到存储区时遇到问题”解决方法

一、问题描述:在安装打印机驱动时,出现错误提示“试图将驱动程序添加到存储区时遇到问题”。多次尝试解决未果,经过多方查找并...

-

Windows系统如何更改软件安装默认位置

我们在使用电脑过程中,难免需要自己安装一些软件,又不想把软件安装在系统分区。安装软件时又不想每次都去更改安装位置,有没有...

-

- 热门文章

-

-

Windows 11 上应禁用的 15 项功能

Windows11具有大量特性和功能,可满足广泛的用户需求。然而,并非所有这些功能都是普遍必要或理想的。 ...

-

让电脑盘符右键中的格式化不起作用——WIN10\WIN8.1测试通过

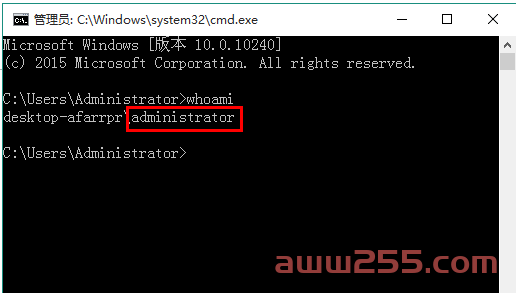

以下内容有不妥之处,敬请指正。一、查看当前电脑登录的用户名称按下键盘上的Win+R组合键,打开运行对话框。输入cmd并按...

-

有趣的CSS - 多彩变化的按钮

这个按钮效果主要使用 :hover 、:active 伪选择器以及 animat...

-

Python 实现一个简单的中文分词处理?

在Python中,实现一个简单的中文分词处理,我们可以采用基于规则的方法,比如最大匹配法、最小匹配法、双向匹配法等。但更...

-

国产麒麟系统开机没有网络需要点一下这个设置

问题描述: 一台国产电脑网线连接正常,打开网页后显示无法访问,那么是...

-

- 最近发表

-

- 佳能DR-C125扫描仪英文 维修手册

- 奥图码 IS802 投影仪完美修复 案例

- 3DM game 游戏运行库合集离线安装包 解决各种报错 安装Windows组件

- DirectX修复工具 增强版V4.3 VBcom 解决dll文件报错

- 佳能 IR ADV C250 C350 C351 彩色复印机中文维修手册+零件手册

- 佳能 iR ADV C2230 C2225 C2220 C2220L 彩色复印机中文维修手册+零件手册

- 佳能 IR ADV C2030 C2025 C2020 彩色复印机 维修手册

- 佳能 iR ADV 8105PRO 8085PRO 8095PRO 8105 8095 8085 复印机中文维修手册

- 佳能 iR ADV 6555 6565 6575 复印机中文维修手册

- 佳能 iR ADV 6255 6265 6275 复印机中文维修手册+零件手册

-

录屏王(1)西游记(1)钢铁皇朝(1)FTP Rush(1)升级固件(1)青雪(1)字体(1)沉浮(1)客户端(1)屏幕录像(1)基士得耶(1)8400(1)联想故障灯(1)苗疆蛊事2(1)桐华(1)轻松自学(1)635KII(1)中英文(1)IP搜索(1)打印系统(1)奇客PDF(1)HP180n(1)精品双播(1)RECPro(1)中控(1)Saver(1)0x000003e3解决(1)拆解(1)CrystalDiskInfo(1)维修召唤M2(1)圣墟(1)Brother(1)网络技术(1)iframe(1)BHmini19HT(1)考勤机软件(1)Movavi Screen Recorder(1)夜的命名术(1)print spooler(1)077 900(1)自动缩放(1)清洗打印头(1)窗体初始(1)成像装置(1)IP修改(1)按键无反映(1)灯闪(1)烈火(1)自学(1)初始化(1)

发表评论 已有 0 评论